近年来,Transformer的诞生使得其在文本领域大放异彩,但是,由于图结构的复杂性以及其连续性,Transformer框架在图表示上始终表现的不尽人意,传统的图神经网络算法依然具有垄断地位。在这个基础上,本文成功通过3种编码,来实现Transformer在图表示领域的应用。

1.引言

Transformer体系结构已经成为许多领域的主导选择,例如,如自然语言处理和计算机视觉[1]。然而,它还没有达到竞争性在流行的图表级别预测排行榜上的表现比较主流GNN变种。在本文中,我们通过介绍Graphormer解决了这个问题,它是建立在标准Transformer之上的体系结构,并能在广泛的图表示上获得优异的结果学习任务,特别是最近的OGB大规模挑战[2]。我们的关键洞察到在图中使用Transformer是有效编码的必要将图的结构信息导入模型。为此目的,我们提出几点建议简单而有效的结构编码方法,以帮助Graphormer更好的模型图结构的数据。此外,我们在数学上刻画了表达的特征用我们编码结构的方式来展示图的信息,许多流行的GNN变体可以覆盖作为特殊Graphormer特例。

2.模型

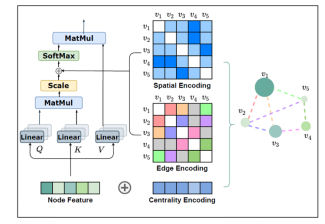

模型的整体结构如图1所示:

图1 Graphormer框架

2.1 中心性编码

基于节点间的语义相关性,计算节点间的注意分布。然而,衡量一个节点在图中的重要性的节点中心性通常是很强的理解图表的信号[3]。例如,有大量粉丝的名人是预测社交网络趋势的重要因素。这些信息被忽略了在当前的关注计算中,我们认为这应该是Transformer的一个有价值的信号模型。

在Graphormer中,我们使用度中心性,这是中心性的标准度量之一文献,作为神经网络的附加信号。具体来说,我们发展了一种中心性根据节点的度和赋值两个实值嵌入向量的编码方法出度。当中心性编码应用于每个节点时,我们只需将其添加到节点特性中作为输入。

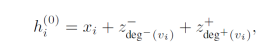

其中 为图中节点的特征向量,

为图中节点的特征向量, 和

和 分别为图中各个节点的入度编码和出度编码。通过在输入端使用中心性编码,softmax注意可以捕获该节点在查询和键中的重要性信号。因此,模型可以同时捕获语义注意机制中的相关性和节点重要性。

分别为图中各个节点的入度编码和出度编码。通过在输入端使用中心性编码,softmax注意可以捕获该节点在查询和键中的重要性信号。因此,模型可以同时捕获语义注意机制中的相关性和节点重要性。

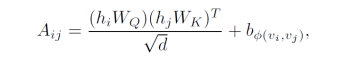

2.2 空间性编码

Transformer的一个优势是它的全局接收场。在每个Transformer层中,每个标记可以注意到任何位置的信息,然后处理其表示。但这种操作有一个副产品问题,即模型必须明确地指定不同的位置或编码位置上的依赖性(如位置性)的层。对于连续的数据,我们可以给每个位置一个嵌入(即绝对位置编码)作为输入,或者对任何两个位置的相对距离进行编码。两个位置的相对距离(即相对位置编码)在转化器层中编码。

然而,对于图来说,节点不是作为一个序列排列的。它们可以位于一个多维的空间,并通过边连接。为了在模型中对图的结构信息进行编码,我们提出了一种新的空间编码模型。具体来说,对于任何图 ,我们考虑一个函数

,我们考虑一个函数 ,他代表图中节点

,他代表图中节点 和

和 的空间关系,所以这里选择了节点间的最短路径来代表两者的空间位置关系。

的空间关系,所以这里选择了节点间的最短路径来代表两者的空间位置关系。

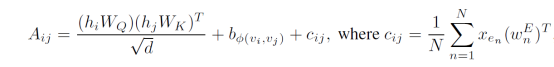

2.3 边缘性编码

为了更好地将边缘特征编码到注意力层,我们提出了一种新的边缘编码方法。我们认为连接它们的边缘应该像[33, 48]中那样被考虑到相关关系中。对于每个有序的节点对,根据其最短路径,按照每一条边的特征向量与对应初始化编码矩阵的乘积进行平均,得到最后的编码向量。

3. 实验结果

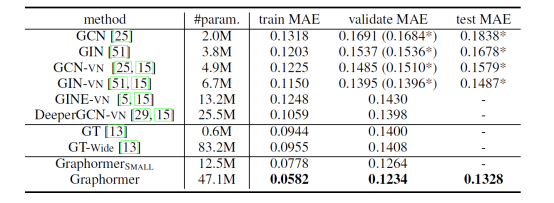

表1 各个模型的实验结果

与之前最先进的GNN架构相比,Graphormer明显地超过了GINVN有很大的优势,例如,相对有效的MAE下降11.5%。注意到测试数据集是公开的,而测试MAE而Graphormer的测试MAE是由OGB团队对5%的测试数据进行评估的。我们进一步发现,提出的Graphormer没有遇到过度平滑的问题。也就是说,训练和验证的误差随着模型的深度和宽度的增长而不断下降。模型的深度和宽度而下降。

4.结论

我们已经探索了Transformer在图形表示方面的直接应用。通过三种新的图结构编码,提出的Graphormer在广泛的流行的基准数据集。虽然这些初步结果令人鼓舞,但仍有许多挑战。例如,自我注意模块的二次复杂性限制了Graphormer在大图上的应用。因此,未来有必要开发高效的Graphormer。性能方面通过利用领域知识驱动的编码,可以期望在特定的图的数据集。最后,在使用Graphormer提取节点时,需要一个适用的图形采样策略。我们把它们留给未来的工作。

5. 参考文献

[1] Jinheon Baek, Minki Kang, and Sung Ju Hwang. Accurate learning of graph representations with graph multiset pooling. ICLR, 2021.

[2] Dominique Beaini, Saro Passaro, Vincent Létourneau, William L Hamilton, Gabriele Corso, and Pietro Liò. Directional graph networks. In International Conference on Machine Learning, 2021.

[3] P David Marshall. The promotion and presentation of the self: celebrity as marker of presentational media. Celebrity studies, 1(1):35–48, 2010.