2024年6月,第18届国际语义评估研讨会 SemEval 2024在墨西哥举办。期间,组委会揭晓了今年SemEval的评测结果,实验室由李诗怡、李岱霖、王楚涵、邹鑫同学组成的两支参赛队伍,在实验室老师们的指导下分别在Task 4:Multilingual Detection of Persuasion Techniques in Memes(多语言模因中说服技巧的检测)中的Subtask 1和Subtask 2b两个赛道荣获第一名的优秀成绩。

SemEval是国际著名的语义评测研讨会,从1998年开始举办,通过设置一系列的评测任务,推动自然语言处理和数据挖掘领域研究的发展。今年SemEval共包含10个任务,覆盖语义关系、话语与论证、大型语言模型(LM)能力、知识表示与推理等领域。会议论文集包含任务描述论文10篇和系统描述论文279篇。

SemEval-2024 Task 4分为三个子任务:判断模因是否使用了说服技巧、在模因的“文本内容”中识别说服技巧、跨模因的文本和视觉组件识别说服技巧(多模态任务)。该任务共吸引了153支队伍注册参与,最终有英属哥伦比亚大学、慕尼黑工业大学、加利福尼亚大学、欧洲电信学院等国际知名高校与企业共计48支队伍提交了结果,并有32篇系统描述论文被提交。

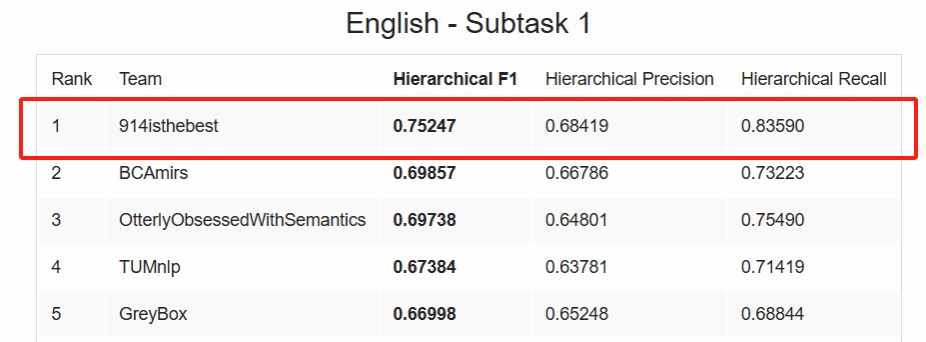

实验室队伍914isthebest提出了一种基于思维链的数据增强方法,针对原数据集的占比较少的标签进行扩充。同时基于领域内预训练,软投票的策略,有效提高了模因说服技巧分类的性能,在Subtask 1荣获第一名。结果排行表如下(数据来自于主办方的赛道总结论文《SemEval-2024 Task 4: Multilingual Detection of Persuasion Techniques in Memes》):

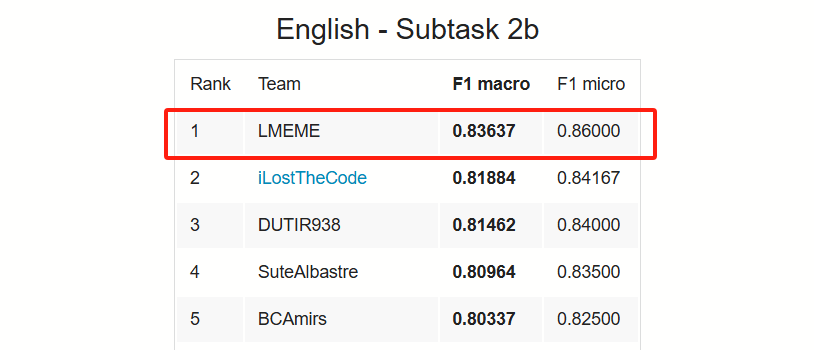

实验室队伍LMEME提出了一种教师-学生融合框架,利用知识蒸馏的方法,有效提高了模型对说服技巧的识别能力,在Subtask 2b荣获第一名。结果排行表如下: